Как я могу скачать весь сайт?

Как я могу скачать все страницы с сайта?

Любая платформа в порядке.

24 ответа

HTTRACK работает как чемпион по копированию содержимого всего сайта. Этот инструмент может даже захватить части, необходимые, чтобы веб-сайт с активным содержимым кода работал в автономном режиме. Я поражен тем, что он может воспроизводить в автономном режиме.

Эта программа сделает все, что от вас требуется.

Хорошей охоты!

Wget - классический инструмент командной строки для решения подобных задач. Он поставляется с большинством систем Unix/Linux, и вы можете получить его и для Windows. На Mac Homebrew - самый простой способ установить его (brew install wget).

Вы бы сделали что-то вроде:

wget -r --no-parent http://site.com/songs/

Для получения дополнительной информации см. Руководство по Wget и его примеры, например:

Используйте wget:

wget -m -p -E -k www.example.com

Варианты объяснены:

-m, --mirror Turns on recursion and time-stamping, sets infinite

recursion depth, and keeps FTP directory listings.

-p, --page-requisites Get all images, etc. needed to display HTML page.

-E, --adjust-extension Save HTML/CSS files with .html/.css extensions.

-k, --convert-links Make links in downloaded HTML point to local files.

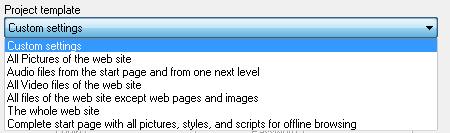

http://www.internetdownloadmanager.com/ имеет утилиту Site Grabber с множеством опций, которая позволяет вам полностью загрузить любой веб-сайт, какой вы захотите, так, как вы этого хотите.

Вы можете установить ограничение на размер загружаемых страниц / файлов.

Вы можете установить количество посещаемых филиалов.

Вы можете изменить поведение скриптов / всплывающих окон / дубликатов

Вы можете указать домен, только под этим доменом будут загружены все страницы / файлы, соответствующие требуемым настройкам.

Ссылки могут быть преобразованы в автономные ссылки для просмотра

У вас есть шаблоны, которые позволяют вам выбрать вышеуказанные настройки для вас

Однако программное обеспечение не является бесплатным - посмотрите, подходит ли оно вам, используйте ознакомительную версию.

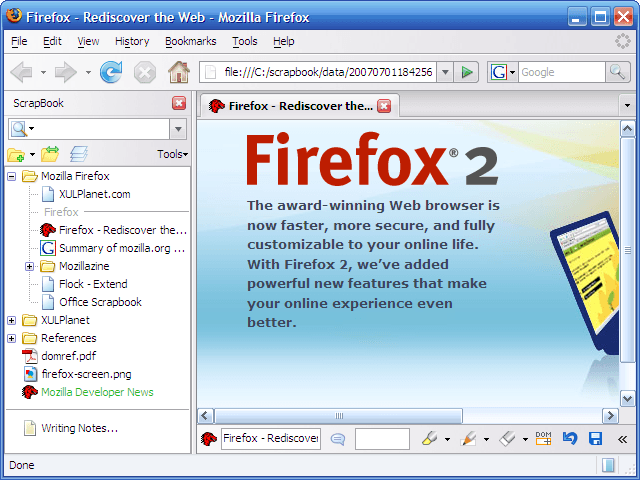

Вы должны взглянуть на ScrapBook , расширение Firefox. Имеет режим углубленного захвата .

Мне нравится Offline Explorer .

Это условно-бесплатная программа, но она очень хорошая и простая в использовании.

Я расскажу об онлайн буферизации, которую используют браузеры...

Как правило, большинство браузеров используют кеш просмотра, чтобы некоторое время хранить файлы, которые вы загружаете с веб-сайта, чтобы вам не приходилось загружать статические изображения и контент снова и снова. Это может немного ускорить процесс при некоторых обстоятельствах. Вообще говоря, большинство кешей браузера ограничены фиксированным размером, и когда он достигает этого предела, он удаляет самые старые файлы в кеше.

Интернет-провайдеры, как правило, имеют кэширующие серверы, на которых хранятся копии часто используемых веб-сайтов, таких как ESPN и CNN. Это избавляет их от необходимости посещать эти сайты каждый раз, когда кто-то из их сети посещает их. Это может привести к значительной экономии в количестве дублированных запросов к внешним сайтам к провайдеру.

Я не делал этого много лет, но есть еще несколько утилит там. Вы можете попробовать Web Snake. Я считаю, что использовал это много лет назад. Я сразу вспомнил имя, когда прочитал твой вопрос.

Я согласен со Стейси. Пожалуйста, не забивайте их сайт. Очень плохой.

Teleport Pro - это еще одно бесплатное решение, которое копирует все файлы из любой вашей целевой области (также есть платная версия, которая позволит вам перетягивать больше страниц контента).

Попробуйте BackStreet Browser .

Это бесплатный, мощный автономный браузер. Высокоскоростная многопоточная программа для загрузки и просмотра веб-сайтов. Делая несколько одновременных запросов к серверу, BackStreet Browser может быстро загрузить весь веб-сайт или часть сайта, включая HTML, графику, Java-апплеты, звуковые и другие определяемые пользователем файлы, и сохраняет все файлы на жестком диске, в их исходном формате, или в виде сжатого ZIP-файла и просмотра в автономном режиме.

Для Linux и OS X: я написал grab-site для архивирования целых сайтов в файлы WARC. Эти файлы WARC могут быть просмотрены или извлечены. grab-site позволяет вам контролировать, какие URL-адреса пропустить, используя регулярные выражения, и их можно изменить, когда выполняется сканирование. Он также поставляется с широким набором настроек по умолчанию для игнорирования нежелательных URL.

Существует веб-панель мониторинга слежения, а также дополнительные опции для пропуска видеоконтента или ответов определенного размера.

DownThemAll - это надстройка Firefox, которая загружает весь контент (например, аудио- или видеофайлы) для определенной веб-страницы одним щелчком мыши. Это не загружает весь сайт, но это может быть то, что вопрос искал.

Мощность wget

Хотя wget уже упоминался, этот ресурс и командная строка были настолько просты, что я подумал, что это стоит упомянуть:wget -P /path/to/destination/directory/ -mpck --user-agent="" -e robots=off --wait 1 -E https://www.example.com/

Почтенный http://www.freedownloadmanager.org/ имеет эту функцию.

Free Download Manager имеет две формы в двух формах: Site Explorer и Site Spider:

Обозреватель сайта

Site Explorer позволяет просматривать структуру папок на веб-сайте и легко загружать необходимые файлы или папки.

HTML Spider

Вы можете загрузить целые веб-страницы или даже целые веб-сайты с помощью HTML Spider. Инструмент можно настроить для загрузки файлов только с указанными расширениями.

Я считаю, что Site Explorer полезен для просмотра папок, которые нужно включить / исключить, прежде чем пытаться загрузить весь сайт, особенно когда на сайте скрывается целый форум, который вы, например, не хотите загружать.

Как я могу загрузить весь сайт?

В моем случае я хотел скачать не весь сайт, а только поддомен, включая все его поддомены.

В качестве примера я попробовал:

wget -E -k -m -np -p https://www.mikedane.com/web-development/html/

который работал нормально.1

По моему опыту, это не всегда позволяет получить все поддомены или PDF-файлы, но я получил полнофункциональную копию, которая отлично работает в автономном режиме.

Вот значения флагов, которые я использовал, согласно :2

-E – приведет к добавлению суффикса .html к локальному имени файла.

-k – преобразует ссылки, чтобы сделать их пригодными для локального просмотра

-m – включает рекурсию и отметки времени, бесконечная глубина рекурсии – будут загружаться

только файлы ниже определенной иерархии

-p — скачать все файлы, необходимые для корректного отображения страниц

Ссылка

1 Если вы попробуете, ожидайте, что загрузка составит около 793 КиБ.

В предыдущей версии у меня былоindex.htmlв конце URL-адреса. В этом нет необходимости. Это может даже привести к сбою загрузки.

2 Что касается-npфлаг, исключением являются случаи, когда существуют зависимости вне иерархии.

Например, я сделал загрузку, для которой указанные CSS-файлы находятся в другом поддомене.

Тем не менее, поддомен, содержащий файлы CSS, также был загружен, чего мы, конечно же, и хотим.

Cyotek WebCopy также кажется хорошей альтернативой. В моей ситуации при попытке загрузить сайт DokuWiki в настоящее время на нем отсутствует поддержка CSRF/SecurityToken. Вот почему я выбрал Offline Explorer , как уже говорилось в ответе выше.

Вы можете использовать ниже бесплатные онлайн-инструменты, которые сделают ZIP-файл со всем содержимым, включенным в этот URL

Сохранить страницу МЫ

Отличное расширение для Chrome и Firefox, которое загружает большую часть / весь контент веб-страницы и сохраняет его непосредственно в .html файл.

Я заметил, что на странице галереи изображений я его примерял, он сохранял эскизы, но не полные изображения. Или, может быть, просто не JavaScript, чтобы открыть полные картинки миниатюр.

Но он работал лучше, чем wget, PDF и т. Д. Отличное простое решение для нужд большинства людей.

Загрузка веб-сайта A1 для Windows и Mac — еще один вариант. Инструмент существует уже почти 15 лет и постоянно обновляется. Он имеет отдельные параметры фильтрации сканирования и загрузки, каждый из которых соответствует шаблону «ограничить» и «исключить».

Загрузите HTTracker, он загрузит веб-сайты очень простыми шагами.

ссылка для скачивания: http://www.httrack.com/page/2/

видео, которое может помочь вам: https://www.youtube.com/watch?v=7IHIGf6lcL4

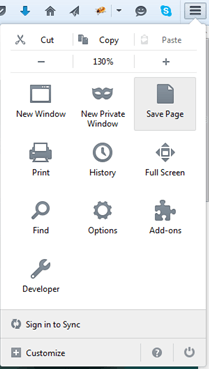

Firefox может делать это изначально (по крайней мере, FF 42). Просто используйте "Сохранить страницу"

Я считаю, что Google Chrome может сделать это на настольных устройствах, просто зайдите в меню браузера и нажмите Сохранить веб-страницу.

Также обратите внимание, что такие сервисы, как pocket, на самом деле не могут спасти веб-сайт и поэтому подвержены гниению ссылок.

И наконец, обратите внимание, что копирование содержимого сайта может нарушать авторские права, если это применимо.