Невозможно скопировать / отразить страницу сайта с помощью WinHTTrack

Я использую Httrack для копирования / зеркалирования сайта и столкнулся с одной проблемой.

Я говорю об этом сайте. Считайте, что я хочу покрыть эту страницу всеми внутренними ссылками (вы можете видеть, как: проблема 6.11, проблема 6.10 с этой страницы). Итак, я попробовал следующее:

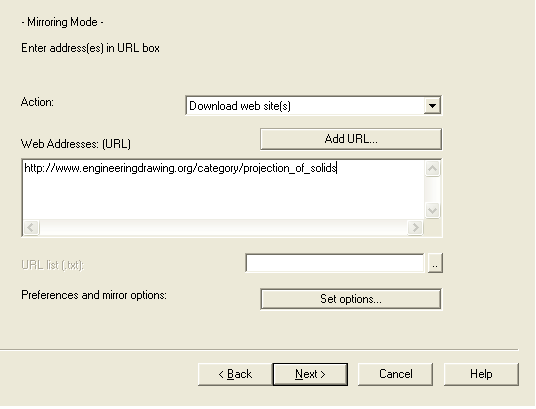

- Введите название проекта и URL:

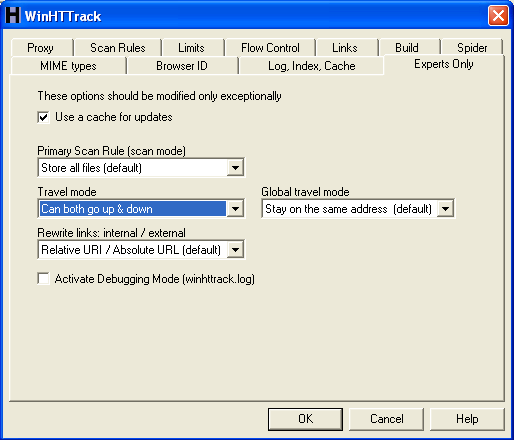

- Заданная опция может идти вверх и вниз как

И я начал зеркалировать, процесс завершился, но когда я просматриваю index.html, главная страница отображается правильно, но дополнительные ссылки (sab-страница, как упоминалось ранее, проблема 6.11, 6.10 и т. Д.) Не отображаются - отображается только фид имени файла.(попробуй сам посмотреть что не так)

Как мне исправить эту проблему?

1 ответ

Я предлагаю вам прочитать FAQ

Вот цитата с веб-сайта WinHTTrack:

Вопрос: некоторые сайты фиксируются очень хорошо, другие нет. Зачем?

Ответ: Есть несколько причин (и решений) для сбоя зеркала. Чтение файлов журнала (и это часто задаваемые вопросы!), Как правило, очень хорошая идея, чтобы выяснить, что произошло.

Ссылки внутри сайта относятся к внешним ссылкам или ссылкам, расположенным в других (или верхних) каталогах, не захваченных по умолчанию - использование фильтров, как правило, является решением, так как это одна из мощных опций в HTTrack. Смотрите выше вопросы / ответы. Правила сайта robots.txt запрещают доступ к нескольким частям сайта - вы можете отключить их, но только с большой осторожностью! HTTrack фильтруется (по умолчанию идентификатором User-agent пользователя) - вы можете изменить идентификацию User-Agent браузера на анонимную (MSIE, Netscape..) - и здесь, используйте эту опцию с осторожностью, так как эта мера могла быть применена чтобы избежать злоупотребления пропускной способностью (см. также часто задаваемые вопросы о злоупотреблении)

Однако есть случаи, которые нельзя (пока) обработать:

Флэш-сайты - нет полной поддержки

Интенсивные сайты Java/Javascript - могут быть поддельными / неполными

Сложный CGI со встроенным перенаправлением и другими хитростями - очень сложен в обращении и поэтому может вызвать проблемы

Проблема синтаксического анализа в HTML-коде (случаи, когда движок обманут, например, из-за ложного комментария (

комментарий (->) обнаружен. Редкие случаи, но могут возникнуть. Отчет об ошибке, как правило, хорош!

Примечание. Для некоторых сайтов может быть полезен параметр "Принудительно старые запросы HTTP/1.0", так как этот параметр использует более простые запросы (например, без запроса HEAD). Это приведет к снижению производительности, но повысит совместимость с некоторыми сайтами на основе cgi.

Оплаченный Есть много причин, по которым сайт не может быть захвачен на 100%, я думаю, что в SuperUser мы очень энтузиасты, но мы не будем обращать внимание на сайт, чтобы узнать, какая система работает сзади (это мое мнение).